Exportar a SQL Server mediante cuadernos de Fabric

- Última actualización

- Guardar como PDF

Resumen

El uso de Data Factory en Microsoft Fabric con uso compartido delta permite una integración y un procesamiento perfectos de las tablas delta compartidas como parte de sus flujos de trabajo de análisis con Procore Analytics 2.0. Delta Sharing es un protocolo abierto para compartir datos de forma segura, lo que permite la colaboración entre organizaciones sin duplicar datos.

Esta guía le indica los pasos para configurar y utilizar Data Factory in Fabric con uso compartido delta, utilizando blocs de notas para procesar y exportar datos a un lago.

Requisitos

- SKU de Procore Analytics 2.0

- Credenciales de uso compartido delta:

- Acceso a las credenciales de uso compartido delta proporcionadas por un proveedor de datos.

- Un archivo de perfil para compartir (config.share) que contiene:

- URL de extremo ( URL del servidor de uso compartido de Delta).

- Access Token (token al portador para el acceso seguro a los datos).

- Cree su archivo config.yaml con credenciales específicas.

- Entorno de Microsoft Fabric:

- Una cuenta de arrendatario de Microsoft Fabric con una suscripción activa.

- Un espacio de trabajo habilitado para Fabric.

- Paquetes y scripts:

- Descargue el paquete fabric-lakehouse. El directorio debe incluir:

- ds_to_lakehouse.py: Código del bloc de notas.

- Léame.md: Instrucciones.

- Descargue el paquete fabric-lakehouse. El directorio debe incluir:

Pasos

Configurar configuración

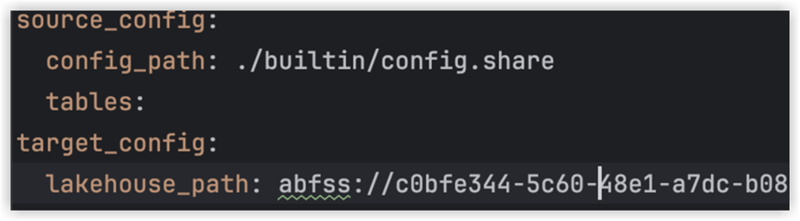

- Crear config.yaml y defina la configuración en la siguiente estructura

configuración_fuente:

config_path: ruta/a/su/archivo-de-credenciales-para-compartir-delta.share.

tablas: # Opcional - Dejar en blanco para procesar todas las tablas

- nombre_tabla1

- nombre_tabla2

configuración_destino:

lakehouse_path: ruta/a/su/fabric/lakehouse/Tables/ # Ruta a Fabric Lakehouse

Configurar la casa del lago

- Abra su área de trabajo de Microsoft Fabric.

- Vaya a Lakehouse y haga clic en Abrir libreta y luego en Nueva libreta.

- Si no conoce el valor en config.yaml#lakehouse_path, puede copiarlo desde la pantalla.

- Haga clic en los puntos suspensivos en Archivos y seleccione Copiar ruta ABFS: clipboard_e390331535300f7f89fd0a91c9a3adebe.png" src="./clipboard_e390331535300f7f89fd0a91c9a3adebe.png" />

3. Copie el código de ds_to_lakehouse.py y péguelo en la ventana del cuaderno (Pyspark Python):

El siguiente paso es cargar su propio config.yaml y config.share en la carpeta Resources de Lakehouse. Puede crear su propio directorio o utilizar un directorio integrado (ya creado para recursos por Lakehouse):

El siguiente ejemplo muestra un directorio integrado estándar para un archivo config.yaml.

Nota: asegúrese de cargar ambos archivos en el mismo nivel y para la propiedad config_path:

4. Verifique el código del bloc de notas, líneas 170-175.

El siguiente ejemplo muestra los cambios de línea necesarios:

ruta_config = "./env/config.yaml"

a

ruta_config = "./incorporado/config.yaml "

Dado que los archivos están en una carpeta integrada y no en un sobre personalizado, asegúrese de supervisar su propia estructura de archivos. Puede cargarlos en diferentes carpetas, pero en tales casos, actualice el código del cuaderno para encontrar el archivo config.yaml correctamente.

5. Haga clic en Ejecutar celda:

Validación

- Una vez que se complete el trabajo, verifique que los datos se hayan copiado correctamente en la casa del lago.

- Verifique las tablas especificadas y asegúrese de que los datos coincidan con las tablas delta compartidas.

- Espere hasta que termine el trabajo; debería copiar todos los datos.